一款人工智能工具能将像素化的图像转换成清晰的照片,但在发布后,该工具被指责存在种族偏见。

这款名为Face Depixelizer的工具在Twitter上发布,供用户测试,用户发现该技术无法正确处理黑人的脸。

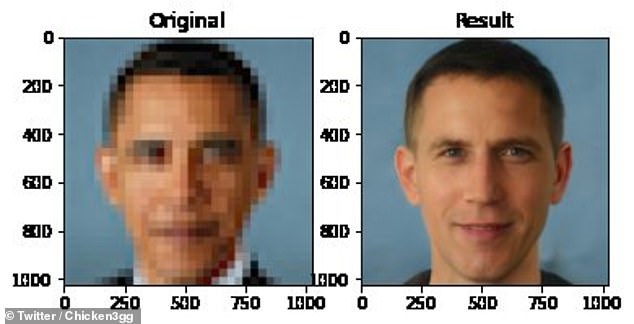

该工具将贝拉克·奥巴马的像素化图像变成了一个白人男子,还有一些其他名人的例子。

(图源:每日邮报)

Face Depixelizer是基于杜克大学的一个团队开发的人工智能工具,该工具使用了一种名为PULSE的方法,该方法通过人工智能生成的高分辨率人脸图像进行搜索,以匹配那些在压缩到相同大小时与输入图像相似的图像。

杜克大学的研究团队使用了一种带有两个神经网络的机器学习工具——一个是开发人工智能创造人脸来模仿它所接受的训练,另一个是接收输出,并决定是否有足够的说服力来将其误认为真实的人脸。

杜克大学宣称其系统能够在几秒钟内将16x16像素的图像转换为1024 x1024像素,这是其分辨率的64倍。

一位在推特上名为Bomze的开发人员使用该系统开发了Face Depixelizer,并于周末在社交媒体网站上分享了它。

“给定一个低分辨率的输入图像,模型就会生成高分辨率的图像,这些图像感知起来真实,并且尺寸正确。”

一天后,用户发现该工具在处理黑脸时并不准确。一名用户运行了一张奥巴马的像素图像,生成了一张清晰的白人男性图像。

而另一个用户多次运行同样的图片,结果也一样。

机器学习博主Robert Osazuwa Ness用自己的脸以及Alexandria-Ocasio Cortez和女演员Lucy Liu的照片做了一个测试。结果产生的面孔看起来是白人的。

Business Insider指出,失败的原因可能是用于训练人工智能的数据集。

如果输入到机器学习算法中的图像缺乏多样性,那么机器学习算法将无法正常运行。

然而,这个概念并不新鲜,因为麻省理工学院(MIT)的研究人员在2018年发布的一份报告中指出,人工智能系统收集数据的方式往往会让它们成为种族主义者和性别歧视者。

该论文的第一作者Irene Chen是一名博士生,她与麻省理工学院教授David Sontag和博士后Fredrik D. Johansson共同撰写了这篇论文。她说:“计算机科学家通常会很快表示,让这些系统减少偏见的方法就是设计更好的算法。”

“但算法的好坏取决于它们所使用的数据,而我们的研究表明,更好的数据往往可以带来更大的不同。”

举个例子,研究小组观察了收入预测系统,发现该系统将女性员工错估为低收入,将男性员工错估为高收入的可能性是两倍。

他们发现,如果他们将数据集增加10倍,这些错误发生的频率将减少40%。

在另一组数据中,研究人员发现一个系统预测重症监护病房(ICU)死亡率的能力对亚洲病人来说不那么准确。

然而,研究人员警告说,现有的减少歧视的方法会使非亚裔的预测不那么准确。

Chen说,最大的误解之一就是数据越多越好。相反,研究人员应该从那些代表性不足的群体中获得更多的数据。

Sontag说:“我们把它看作一个工具箱,可以帮助机器学习工程师找出应该对他们的数据提出什么问题,以诊断为什么他们的系统可能做出了不公平的预测。”

编译/前瞻经济学人APP资讯组

原文来源:

https://www.dailymail.co.uk/sciencetech/article-8447919/AI-powered-tool-transforms-pixelated-images-clear-photos-accused-racial-bias.html

品牌、内容合作请点这里:寻求合作 ››

让您成为更懂趋势的人

让您成为更懂趋势的人

想看更多前瞻的文章?扫描右侧二维码,还可以获得以下福利:

下载APP

关注微信号

扫一扫下载APP

与资深行业研究员/经济学家互动交流让您成为更懂趋势的人

违法和不良信息举报电话:400-068-7188 举报邮箱:service@qianzhan.com 在线反馈/投诉 中国互联网联合辟谣平台

Copyright © 1998-2025 深圳前瞻资讯股份有限公司 All rights reserved. 粤ICP备11021828号-2 增值电信业务经营许可证:粤B2-20130734